0 1

Houston, tenemos un problema

La llegada de Colón a América en 1492 o el descubrimiento de la penicilina en 1928 son algunos ejemplos de hallazgos fruto de errores humanos; de cálculos cartográficos inexactos en el primer caso y de un olvido (limpiar una placa con un cultivo bacteriano) en el segundo.

El naufragio del Titanic, el 14 de abril de 1912, que causó cerca de 1.500 víctimas, se ha considerado resultado de la concurrencia de múltiples errores humanos desde el comienzo del proyecto: fallos en el diseño del buque, negligencias, incompetencia de la tripulación, nefastas decisiones de seguridad de todo tipo, como el insuficiente número de botes salvavidas o vigías sin binoculares, etc.

En el otro lado de la balanza, la odisea espacial del Apolo XIII, en 1970, fue calificada como “el fracaso más exitoso de la historia”. En lugar de alunizar, sus tres tripulantes lograron volver a la Tierra tras la explosión de un tanque de oxígeno en pleno vuelo, que se comunicó al control de la misión con la famosa frase “Houston, tenemos un problema” (más exactamente “hemos tenido”).

Se considera un ejemplo en el que la creatividad y la resiliencia humanas lograron superar un evento catastrófico en el entorno más hostil posible, el espacio exterior.

Ineco ha desarrollado su filosofía Human First, una visión de los análisis de seguridad que integra, de manera novedosa, los aspectos técnicos y humanos que tradicionalmente se estudiaban por separado

En todos estos casos, resultaron decisivos lo que en el ámbito del análisis de riesgos se conoce como “factores humanos y organizacionales”, que es la ciencia que trata de comprender las capacidades y habilidades positivas (inventiva, de adaptación y aprendizaje, de anticipar acontecimientos, etc.), además de investigar una característica intrínsecamente humana: la de fallar, es decir, cometer errores.

0 2

No somos infalibles, pero intentamos mejorar

A lo largo del siglo XX, y particularmente a partir de la segunda mitad con el impulso científico y tecnológico tras dos guerras mundiales, se desarrollaron sistemas industriales y de transporte cada vez más sofisticados y con mayor peso de los componentes tecnológicos. A partir de 1945, en sectores como la energía nuclear y la aviación comercial se constató que los fallos humanos estaban detrás de entre el 70% y 80% de los accidentes y catástrofes, al igual que en el sector ferroviario, entre otros.

Por la naturaleza intrínseca de su actividad y su potencial de riesgo, los sectores civiles donde se plantearon los primeros estudios de fiabilidad humana fueron el aeronáutico y aeroespacial, así como el transporte marítimo y terrestre, la industria química y energética, particularmente la nuclear, y la medicina

Inicialmente, se pone el foco en evitar los fallos técnicos, en los que se centran los primeros estudios de seguridad. Paralelamente, la filosofía, la sociología y la psicología recogieron y analizaron las nuevas inquietudes derivadas del desarrollo tecnológico y los descubrimientos científicos, relacionadas sobre todo con el concepto de incertidumbre. La teoría de la relatividad de Albert Einstein y el desarrollo de la física cuántica dinamitaron los modelos mecanicistas de pensamiento lineal basado en relaciones directas causa-efecto; corrientes como el pensamiento sistémico y el pensamiento complejo proponen superar la visión clásica de buscar el conocimiento de un todo estudiando sus partes de forma aislada.

El pensamiento sistémico (…) nos recuerda que el todo puede superar la suma de las partes (…) en vez de considerar que un factor ‘externo’ causa nuestros problemas, vemos que nuestros actos crean los problemas que experimentamos. Peter M. Senge, “La quinta disciplina. El arte y la práctica de la organización abierta al aprendizaje”, 1992

Por el contrario, estiman que un sistema socio-técnico, ya sea una fábrica de coches, una planta nuclear o un servicio de control aéreo, es más que la simple suma de sus partes, y que las interrelaciones entre los elementos técnicos, humanos y el entorno en el que operan son muy complejas, dinámicas e incluso contradictorias. El objetivo es gestionar el rendimiento y comportamiento de las personas dentro del sistema centrando la evaluación en la interacción del humano con la operación. En la actualidad, con la Inteligencia Artificial creciendo a pasos agigantados, con el debate sobre cómo mantener el control humano sobre ella sobre la mesa, cada vez cobra mayor relevancia el entender la variabilidad del comportamiento, para ‘solucionar’ tecnológicamente los errores humanos.

03

Diseccionando el “fallo humano”

Entretanto, y asumiendo el error como una realidad connatural al ser humano y descartando el “riesgo cero” por irrealizable, se desarrolla el concepto de “seguridad operacional”. OACI, (Organización de Aviación Civil Internacional, creada en 1944) lo define como “el estado donde la posibilidad de dañar a las personas o las propiedades se reduce y mantiene al mismo nivel o debajo de un nivel aceptable mediante el proceso continuo de identificación de peligros y gestión de riesgos”.

El “error humano” en este contexto no se aborda con connotaciones morales de ningún tipo, sino como “el comportamiento de las personas que excede el límite de tolerancia definido para la seguridad de un sistema”, de acuerdo al Instituto Nacional de Seguridad y Salud en el Trabajo (Ministerio de Trabajo, España). Un sistema en el que confluyen elementos técnicos, humanos (las personas) y el entorno, que están interrelacionados e interactúan entre sí.

No podemos cambiar la condición humana, pero sí podemos cambiar las condiciones en las que trabajamos para tener menos errores y una recuperación más fácil. James Reason, psicólogo, “La contribución humana”, 2008.

Los estudios de fiabilidad humana son un área multidisciplinar en el que confluyen diversas ramas de la psicología y la ingeniería, que han propuesto diferentes teorías, técnicas de análisis y modelos sobre la multitud de factores, internos y externos, que inciden en el comportamiento y las decisiones humanas, concluyendo que las personas no pueden analizarse como un simple componente técnico más.

Breve historia del yerro

En las últimas décadas han ido surgiendo una variedad de clasificaciones (taxonomías) de errores humanos según distintos criterios, modelos explicativos, y técnicas y metodologías de estudio. Ya sea con enfoques cuantitativos, (basados en cálculos de probabilidades) o cualitativos (valoración de expertos), o combinaciones de ambos, todas han tratado de desentrañar cómo, en qué circunstancias y por qué se producen los fallos humanos, con el objetivo final de evitar accidentes o incidentes.

Foto: Pablo Neustadt/Ineco

Modelos conceptuales

En 1972 Elwyn Edwards propone el modelo SHELL, que incide en las interrelaciones entre los componentes del sistema: Software, o elementos no físicos como normas, reglamentos, procedimientos, etc. ; Hardware, la estructura física del ámbito de trabajo: equipos, herramientas y maquinarias; Environment, las condiciones internas y externas del entorno de trabajo; y Liveware, es decir, las personas (individuos y equipos).

Por otra parte, el modelo del queso suizo, formulado en 1990 por el profesor de psicología en la Universidad de Manchester James Reason, sintetiza el error humano entendido como la consecuencia, y no la causa, de fallos del sistema, latentes o activos, representados por los agujeros de varias capas o lonchas (las “defensas”) de un queso suizo; el incidente o accidente sólo puede producirse si se alinean varios agujeros.

Técnicas de evaluación de error humano

THERP (Technique for Human Error Rate Prediction), la más conocida, desarrollada por Swain y Guttman en 1983. La herramienta es el “árbol de sucesos” de fiabilidad humana; se aplica en los sectores nuclear, médico, marino, químico, aeronáutico, transporte y construcción.

SHERPA (Systematic Human Error Reduction and Prediction Approach) es un técnica sencilla, cualitativa y cuantitativa, que se aplica en los sectores nuclear, minería, plataformas petrolíferas y correos.

HEART (Human Error Assessment and Reduction Technique) Es un método versátil y rápido de cálculo de confiabilidad humana, basado en nueve descripciones de tareas genéricas. Se ha aplicado en los campos nuclear, químico, médico, aviación y ferroviario.

Entre las específicas del campo nuclear se pueden mencionar: SHARP (Systematic Human Action Reliability Procedure), SLIM (SuccessLikeli Hood Index Methodology) ATHEANA (A Technique for Human Error Analysis), TRC (Time Reliability Curve), CARA (Controller Action Reliability Assessment), INTENT, HCR (Human Cognitive Reliability Model) y NARA (Nuclear Action Reliability Assessment, una versión modificada del método THERP).

En el ámbito aeronáutico, a partir de 1979 se desarrollaron los exitosos programas de Gestión de Recursos de la Tripulación (Crew Resource Management, CRM) para prevenir el error humano, que a lo largo de los años han ido ampliando su alcance desde el piloto (inicialmente las siglas correspondían a Gestión de Recursos de Cabina, Cockpit Resource Management), a toda la tripulación, controladores, etc.

0 4

La pionera aportación de Ineco: FARHRA, lo humano primero

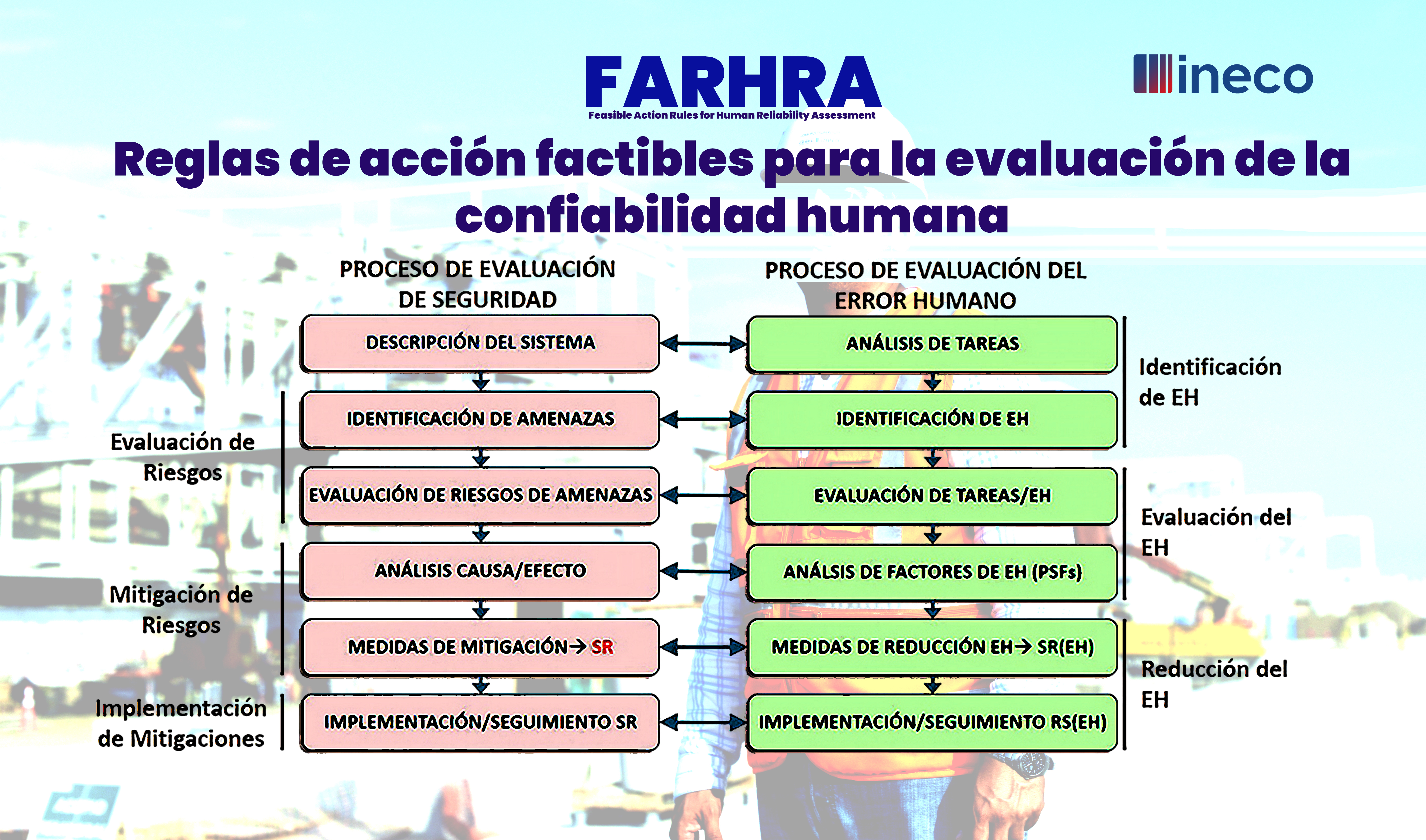

En el marco de Human First se desarrolla la metodología FARHRA (Feasible Action Rules for Human Reliability Assessment, Reglas de acción factibles para la evaluación de la confiabilidad humana), propia de Ineco, que integra, por primera vez en el mercado, los factores humanos y organizacionales en los análisis de riesgos.

El punto de partida es que los comportamientos inseguros de las personas no se consideran causas, sino consecuencias de un entorno y/ o de los factores que pueden afectar al desempeño humano (fatiga, estrés, etc.), y llegar a desencadenar incidentes y/o accidentes.

Esta metodología recibió en 2019 recibió el premio Global Safety Achievement Award de la Organización de Servicios de Navegación Aérea Civil (CANSO) por su enfoque pionero. En 2022 y 2023, respectivamente, la han adoptado Metro de Medellín (Colombia) y la Agencia Espacial Europea (ESA), para su programa Galileo. Además, en 2024 se está utilizando en proyectos con Adif, el administrador estatal de infraestructuras ferroviarias.

La destacada contribución de Ineco a la seguridad del ATM (…) es una verdadera inspiración y un claro ejemplo de cómo los miembros de CANSO están introduciendo innovaciones originales y valiosas prácticas recomendadas a nivel mundial. Simon Hocquard, director general de CANSO, 2019

La metodología se desarrolló en el marco de un proyecto de innovación interna y se estructura en seis etapas. La primera es un análisis de tareas, mediante técnicas tipo Human HAZOP, en línea con las habituales para identificación de amenazas de seguridad, en que se buscan todos aquellos elementos que pueden dificultar su correcta realización y los factores que afectan al desempeño: procedimientos, protocolos de feedback, equipos, factores personales e interpersonales (incluidos los organizacionales), fatiga, estrés, distracciones, conflicto entre seguridad y servicio al cliente, el exceso de confianza, protocolos de comunicaciones, ergonomía…

La clasificación de tareas parte de cinco parámetros, en lugar de los tipos de tarea genéricos del método HEART. De este modo se obtiene un peso global que, para cada tarea, indica su potencial de error, es decir, cómo de fácil es equivocarse en su ejecución.

Para conectar con la seguridad, mediante análisis de causas y efectos se explica la contribución de los errores humanos identificados a las amenazas y su nivel de riesgo o criticidad.

Después se determinan los factores contribuyentes al error. En lugar de las listas genéricas de Condiciones de Producción de Error (EPC) de HEART, de las que se tomó como referencia la estructura, se generaron unas listas más utilizables de factores o PSF (Performance Shaping Factors) que afectan al rendimiento humano.

Por último, combinando los tres aspectos – potencial de error de las tareas, criticidad del error y factores de rendimiento PSF- se pueden establecer órdenes de prioridad para el proceso final: la reducción del error humano. Inicialmente, se utilizó el enfoque NARA (Nuclear Action Reliability Assessment), sustituido y mejorado por el método FARHRA , que proporciona un conjunto mayor de medidas y más alineado con el enfoque habitual en los análisis de riesgo en el sector del transporte.

La ciencia de datos al servicio de lo humano

Foto: kjpargeter/Freepik

Los avances en ciencia de datos y aprendizaje automático también se han aplicado a la metodología de Factores Humanos de Ineco, ante el reto de la mejora continua de la seguridad operacional en todos los modos de transporte. Así, por ejemplo, se han desarrollado IneFIT, un algoritmo y una herramienta para la medición del índice de fatiga de los trabajadores por turnos, basada en un modelo BioMatemático de Fatiga (BioMaF).

Paralelamente, InFACT, es una herramienta de análisis de datos de accidentes e incidentes reales que, mediante algoritmos de aprendizaje automático (machine learning) , es capaz de extraer tendencias sobre los factores humanos subyacentes.

Finalmente, para implantarla en las organizaciones, la compañía ha desarrollado HOPA (Human and Organisational Performance Assurance), una metodología para la gestión del cambio, que combina la metodología Human Factors Case de Eurocontrol con metodologías Agile/Lean Management (gestión ágil) para la detección de riesgos, determinación de medidas de mitigación y seguimiento y monitorización de cambios.

Además, Ineco continúa explorando las aplicaciones de la ciencia de datos y aprendizaje automático en el ámbito de los factores humanos y organizacionales: se están desarrollando metodologías de análisis de la carga de trabajo percibida por las personas a la hora de ejecutar sus tareas, y se está mejorando el algoritmo de cálculo de los índices de fatiga.